概述

Amazon SageMaker Debugger 可以通过实时捕获训练指标(如回归期间的数据丢失),以及在检测到异常时发送警报,轻松优化机器学习(ML)模型。这有助于您立即纠正不准确的模型预测,例如不正确的图像识别。达到所需的准确度后,SageMaker Debugger 会自动停止训练过程,从而减少训练机器学习模型的时间和成本。

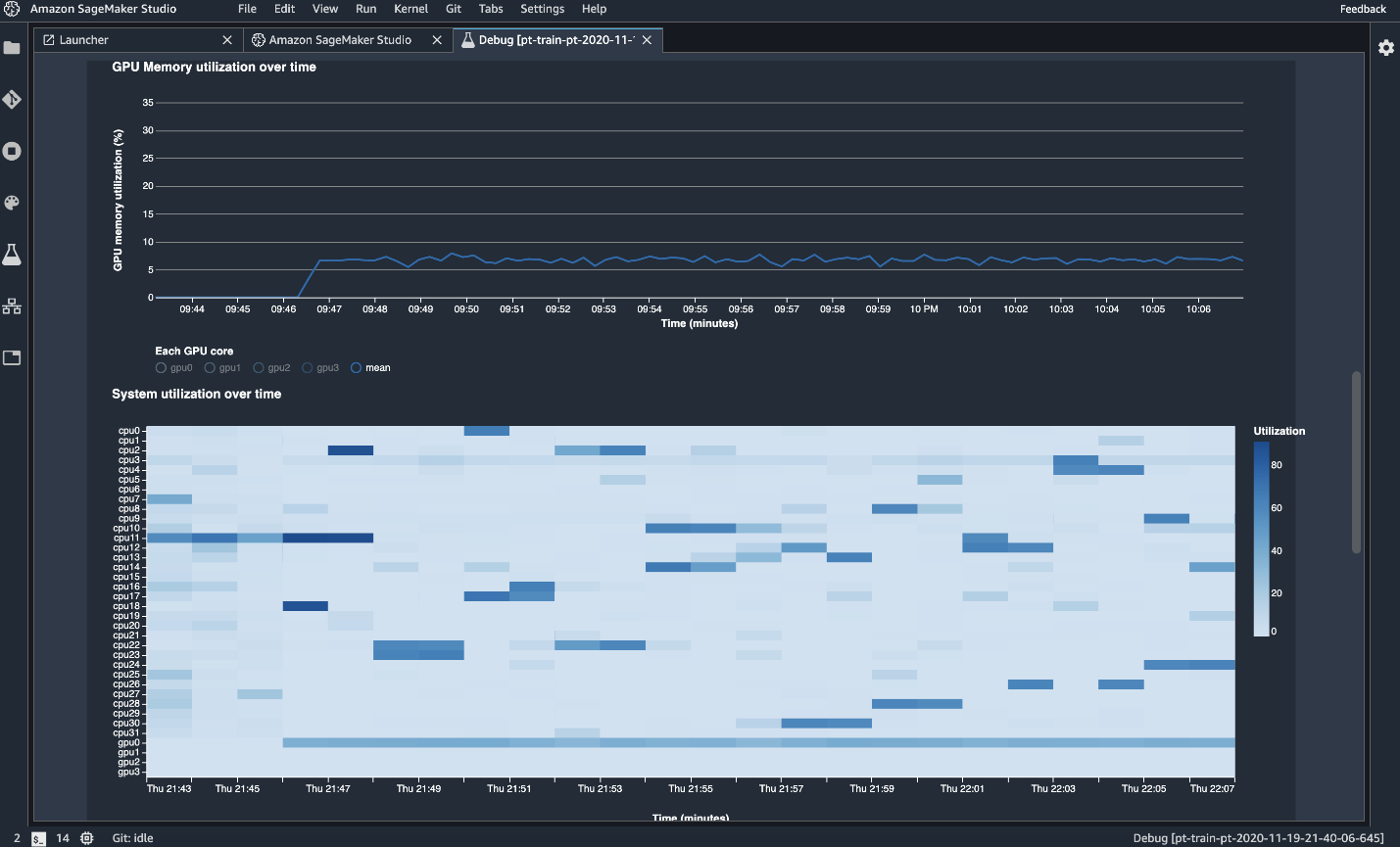

新增功能! Amazon SageMaker Debugger 现在可以自动分析和监控系统资源利用率,并在识别出资源瓶颈(例如过度使用 CPU)时发送警报,从而帮助您更快地训练模型。在 Amazon SageMaker Studio 内训练期间,您可以直观地监控和分析系统资源,包括 CPU、GPU、网络和内存,以便持续提高资源利用率。SageMaker Debugger 将系统资源使用情况与训练作业的不同阶段和训练期间的特定时间点相关联,并提供有关如何调整资源利用率的建议,以帮助您重新分配资源以实现最大效率。监控和分析所有领先深度学习框架(包括 PyTorch 和 TensorFlow)的工作,无需对训练脚本进行任何代码更改。监控和分析系统资源是实时进行的,可帮助您更快地大规模优化机器学习模型。

自动检测、分析和警报

Amazon SageMaker Debugger 可以通过自动检测和提醒您修复常见训练错误(如渐变值变得过大或过小),将训练期间的故障排除从数天缩短到几分钟。警报可以在 Amazon SageMaker Studio 中查看,也可以通过 Amazon CloudWatch 进行配置。此外,SageMaker Debugger 开发工具包使您能够自动检测新的模型特定错误类别,例如数据采样、超参数值和超限值。

监控和分析

Amazon SageMaker Debugger 会自动监控系统资源(如 GPU、CPU、网络和内存)的利用率,并对您的训练作业进行分析,以收集详细的机器学习框架指标。您可以通过 SageMaker Studio 直观地检查所有资源指标。资源利用率的异常与特定操作相关联,以识别瓶颈(例如 CPU 过度使用),以便您可以快速采取纠正措施。此外,还可以下载详细报告进行离线分析。您可以在训练作业开始时或在训练进行中的任何时候对训练运行进行分析。

内置分析

Amazon SageMaker Debugger 具有内置的分析功能,可自动分析训练期间输出的数据,例如输入、输出和称为张量的转换。因此,您可以检测模型是过度拟合还是过度训练,梯度是变得过大还是过小,GPU 资源是否未充分利用,以及训练期间的其他瓶颈。借助 SageMaker Debugger,您还可以创建自己的自定义条件来测试训练作业中的特定行为。这些条件可以调用停止训练作业和发送短信或电子邮件等操作。提前停止训练作业将有助于降低次优模型的训练成本,并更快地开发出更好的原型。

跨机器学习算法和深度学习框架的广泛支持

Amazon SageMaker Debugger 支持机器学习框架,包括 TensorFlow、PyTorch、Apache MXNet、Keras 和 XGBoost。SageMaker 针对这些框架的内置容器预装了 SageMaker Debugger,使您能够轻松监控、分析和调试训练脚本。默认情况下,SageMaker Debugger 会在训练期间监控系统硬件的利用率和损失,而不会编写额外的代码来单独监控每个资源。

与 Amazon Lambda 集成

Amazon SageMaker Debugger 与 Amazon Lambda 集成,因此您可以对警报的结果采取行动。例如,当检测到非收敛操作(如损失)持续增加而不是随着时间的推移减少时,Amazon Lambda 函数可以自动停止训练作业。Amazon Lambda 会提供停止训练作业的通知,以便您可以在机器学习开发和训练的早期阶段降低成本并实现预期效果。